最新プロンプティング最前線:PdMとCX責任者が成果を最大化する戦略フレームと検証ループ、運用指標と品質監査を統合した実践ロードマップの完全版と改善シナリオ集成ガイドラインと定着施策の総覧と投資判断基準

生成AIのプロンプト設計は、対話生成だけでなく意思決定支援や自動化ワークフローの性能を左右し、部署横断でのデジタル変革とコンプライアンス体制を同時に進化させる主要レバーとなりました。しかし、PdMやCX責任者が定量指標を持たずに導入を進めると、KPIのばらつきやオペレーション負荷が膨らみ、説明責任やガバナンスに対する経営層の信頼を失い、現場の改善サイクルも停滞しかねません。本稿では、国内外の先進事例[^1]と検証フレーム[^2][^3]に加え、プロンプト改善のデータ連携や人材育成の実践知を踏まえ、今日から運用に落とし込める戦略全体像と実装ロードマップを整理します。

タスク分類×推奨プロンプトの一覧

PdMがプロンプト活用を粒度で捉えるには、タスク種別ごとに意図・出力形式・チューニング余地を分解し、再現性のあるテンプレートとして管理しながら、KPIや監査ログとの紐付けを一元化し、依頼部門への教育資材として循環させ、継続的な検証計画と連動させることが不可欠であり、以下の一覧はその起点となる不可欠な基盤です。

| タスクカテゴリ | 推奨プロンプト構造 | 出力仕様 | 主要KPI | 運用支援 | CTA |

|---|---|---|---|---|---|

| 顧客問い合わせ要約 | ロール指定+成功条件+NG語彙の順で明示 | JSON Lines、信頼度スコア、要約100字以内 | 正確率>=0.92、平均応答時間<=6s | Zendesk連携、ガードレール警告Slack通知 | テンプレートDL |

| 商品説明自動生成 | 構造化属性→USP抽出→CTA文案 | Markdown、トーン指定、画像提案3件 | CTR向上率+15%、生成コスト<=$0.02 | PIM同期、コピー監査チェック | テンプレートDL |

| 意思決定支援レポート | 要約→インサイト→リスク→推奨策→根拠 | 表形式、指標比較、判断信頼度0-1 | 判断一致率>=0.9、リードタイム-30% | BIダッシュボード連動、承認ワークフロー | テンプレートDL |

| 契約レビュー補助 | 条項抽出→リスク分類→修正案→参考判例 | 表形式PDF、引用条文リンク、信頼度 | リスク検知率>=0.95、レビュー時間-40% | DMS連携、弁護士レビュー記録 | テンプレートDL |

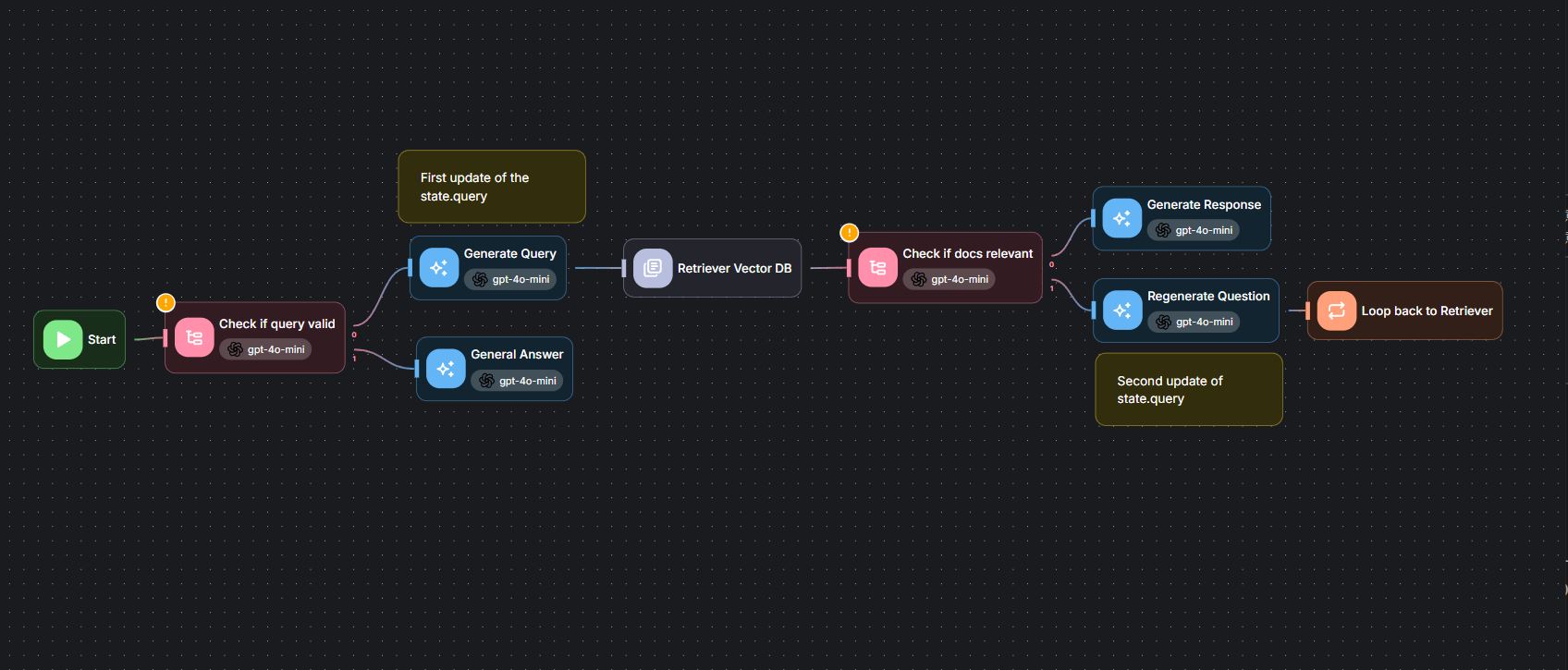

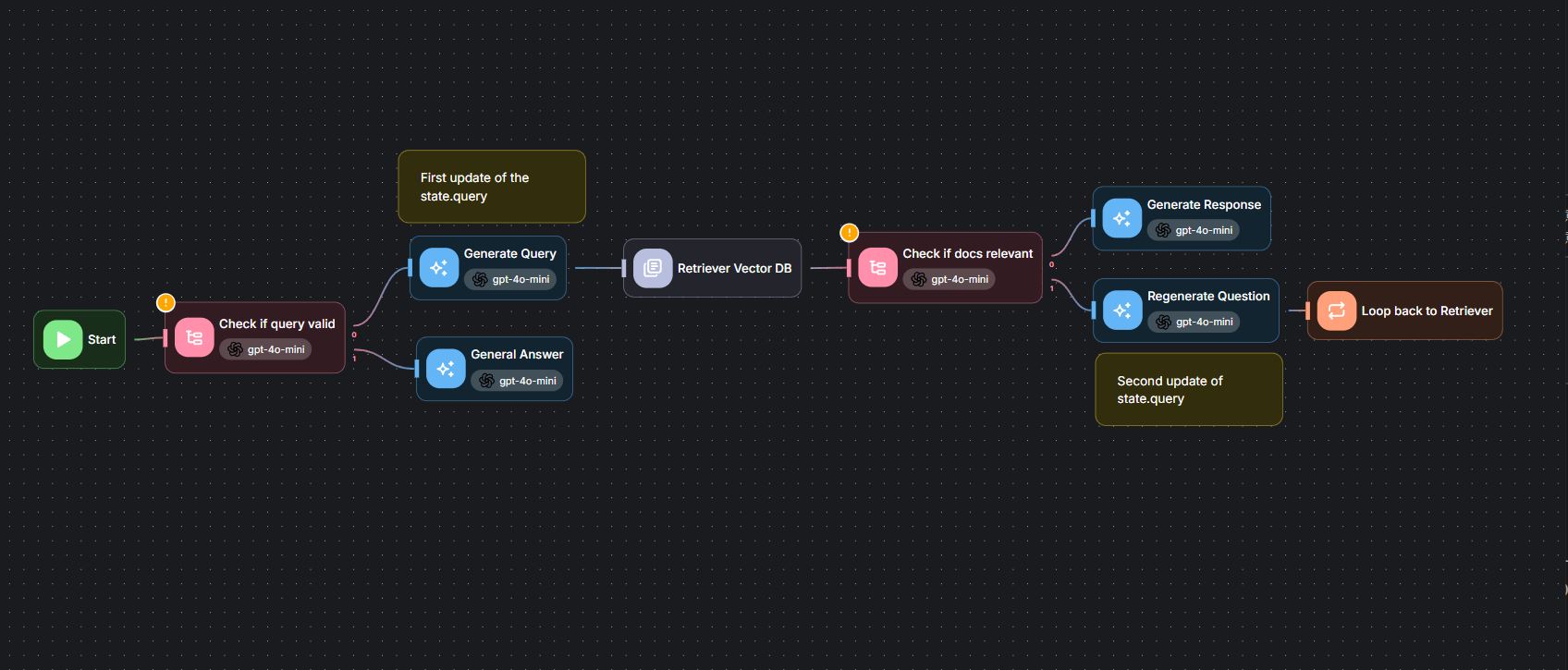

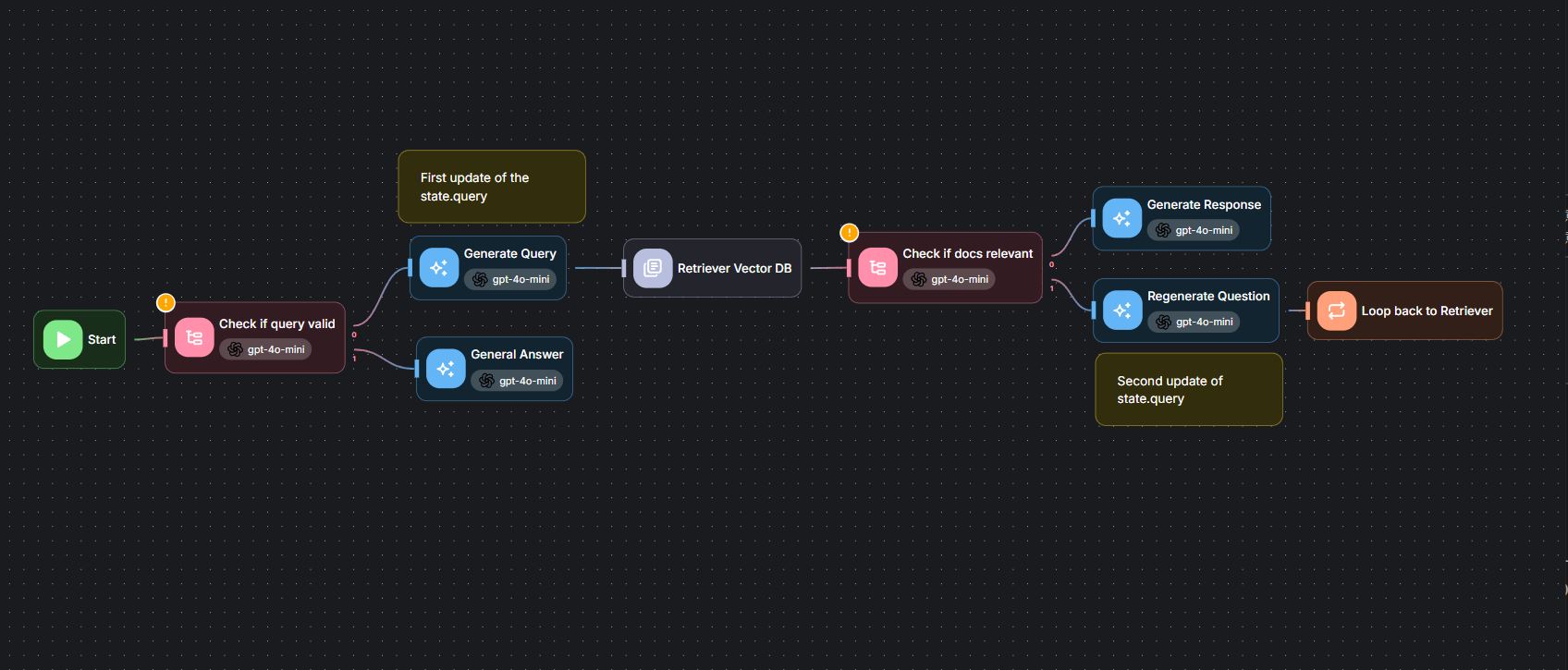

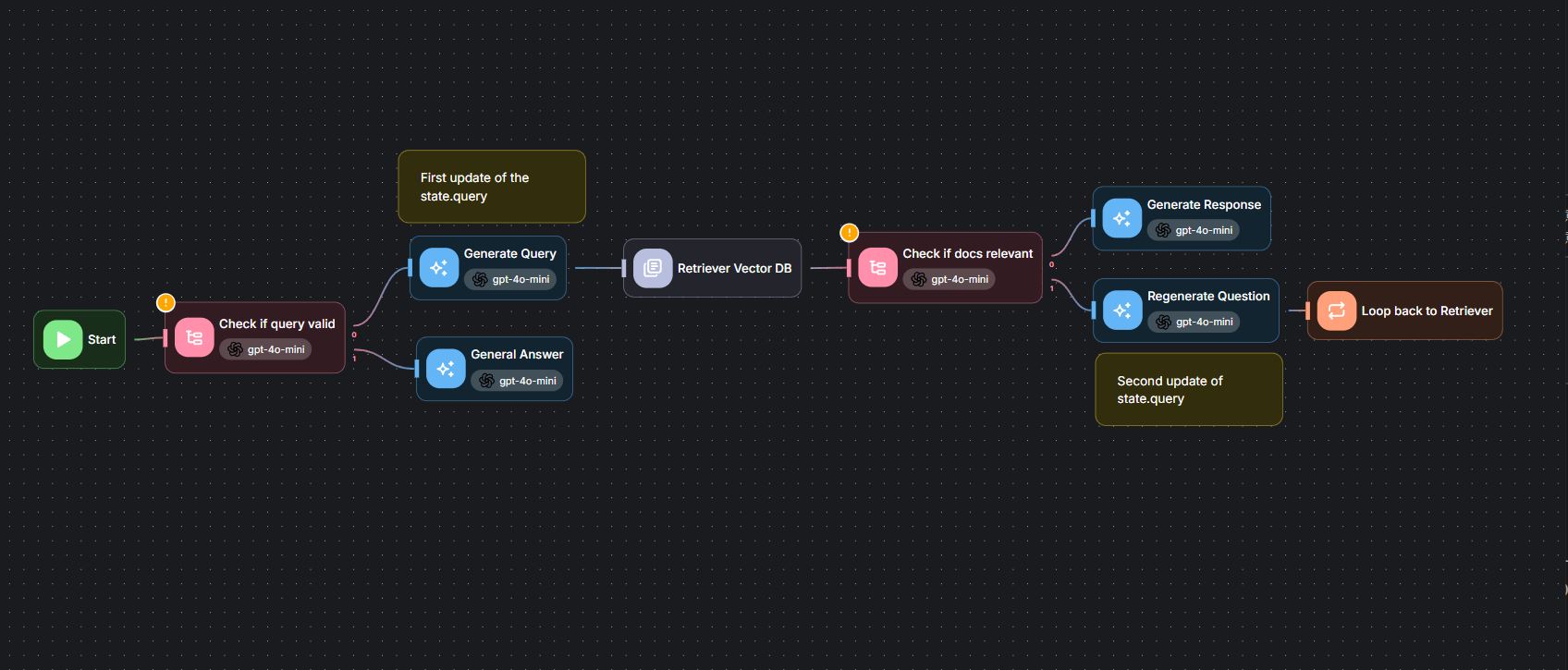

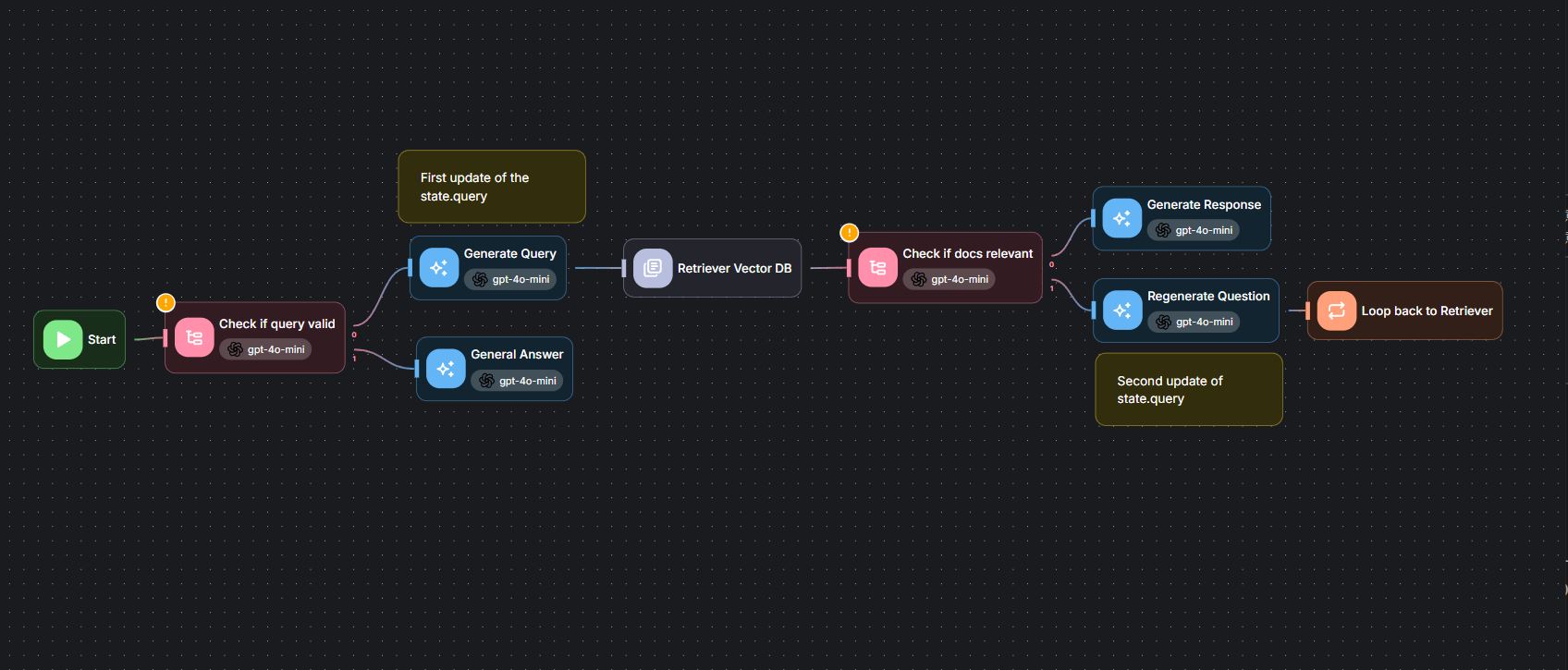

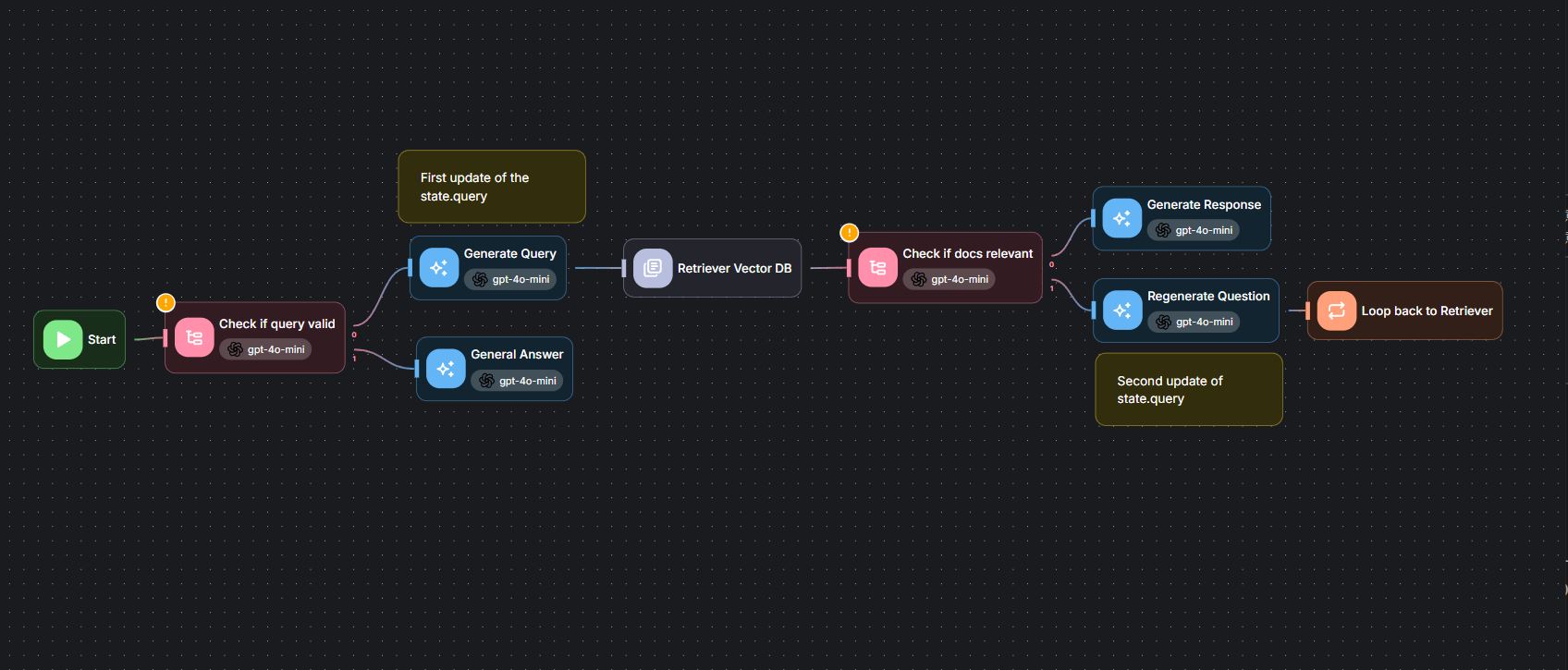

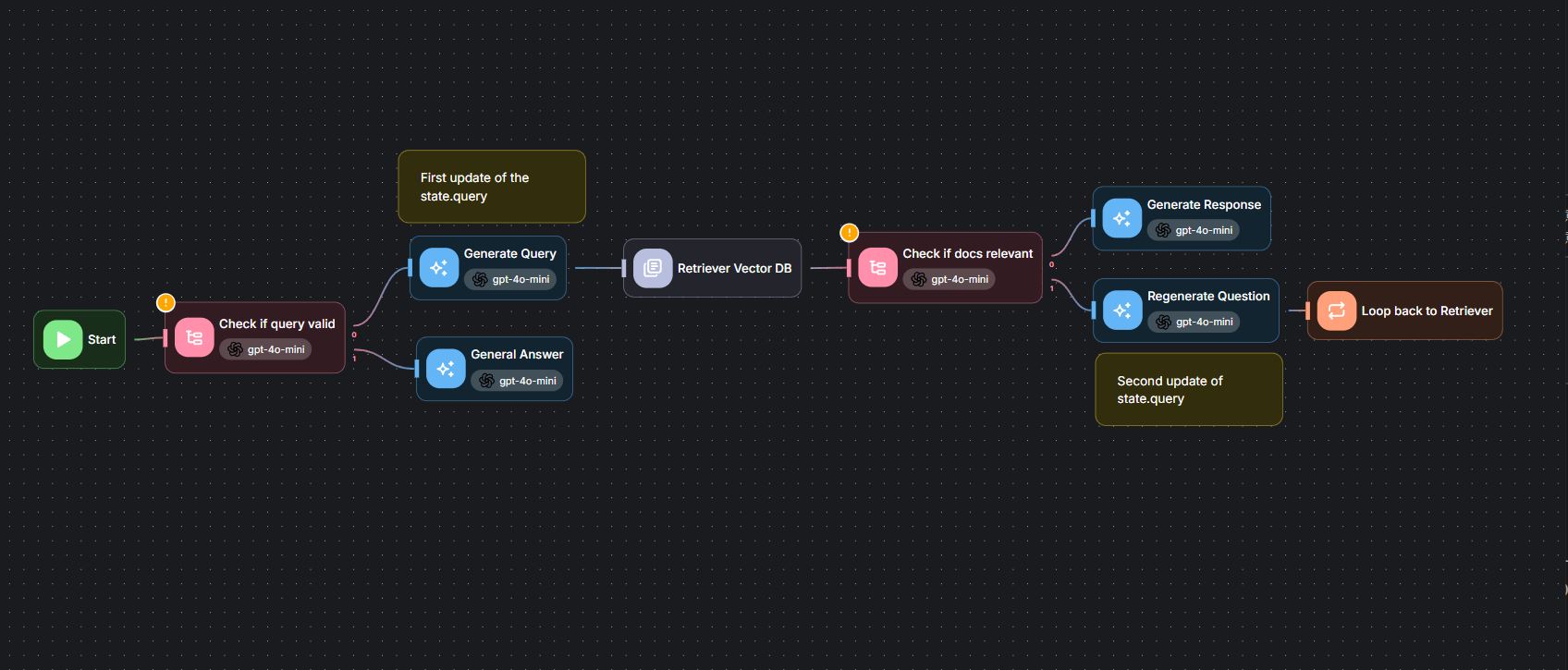

| RAG回答生成 | 質問再構成→検索方針→根拠提示→要約 | 引用3件以内、信頼度、補足質問提案 | 引用整合率>=0.97、回答遅延<=5s | ベクトルDB再学習、ドキュメント監査 | テンプレートDL |

| コードレビュー支援 | 差分解析→脆弱性→性能→テスト提案 | Markdown、影響関数、推奨テストケース | 重大欠陥検知率>=0.9、レポート時間-35% | CI統合、セキュリティ審査ログ | テンプレートDL |

次はフレームワークを用いて自社タスクの成熟度診断基準を揃え、投資優先度を可視化します。診断結果を起点に次章では評価ループ設計へ接続する導線と失敗例の回避策を解説します。

タスク診断フレーム

タスク診断を高速化するには、目的、対象データ、利用者の熟練度、リスク許容度、ガードレールの有無をスコアリングし、プロンプトの粒度と支援機能の投資順序を決定する評価枠組みが重要です。加えて、データ同期やエラーログの収集ルートを事前に定義しないと、最適化ループが寸断され、改善施策の効果測定ができません。さらに、診断結果を意思決定会議で説明可能にする可視化テンプレートも合わせて準備しましょう。これらを標準化すると、外部監査やリリース審査にも対応しやすくなります。

それでは診断スコアを反映した具体的なプロンプト改善ステップを順に確認し、段階的に成熟度を高めます。最初はデータ理解を深めるStep 1から着手し、想定用途の輪郭を固める準備を整えましょう。

Step 1: 語彙とガードレールを固定するインテント整理

診断初期のStep 1では、対象ドメインの語彙やデータ粒度、必須メタ情報を洗い出し、プロンプトに含める固有名詞と除外語を確定します。関係者インタビューで業務の成功判定基準を文脈化し、反例を体系的に収集することで、後段の評価データセットとガードレール要件が短期間で整います。さらに、FAQや過去チケットを分類し、潜在的な誤解リスクを可視化しておくと修正コストを予測しやすくなります。これにより、以降のプロンプト検証で扱う想定外入力を事前に定義でき、障害再現テストの設計コストも抑制可能です。

目的: 業務チケットの分類要件を整理する

入力: {{ticket_excerpt}}

思考手順: 1) 文脈確認 2) 禁止語検出 3) 成功基準照合

出力形式: {"category": "", "severity": "", "notes": ""}

検証メモ: dataset_id={{dataset_id}}

Step 1

続くStep 2では収集した事例をもとにプロンプトの構造化テンプレートを整備します。準備した反例セットを活かし、次章で指示文と制約条件の棲み分け方を確認しましょう。

Step 2: 指示と制約を体系化するプロンプト骨子設計

Step 2では、ターゲットLLMの推論特性を踏まえてロール設定、入力指示、思考手順、出力フォーマットの順に骨子を整えます。Step 1で把握した語彙とガードレールをテンプレート化し、変数やチェックリストを明示することで、オペレーターが迷わず更新できる構造化プロンプトが完成します。さらに、バージョンと利用シーンを冒頭コメントで宣言すると、誤用リスクが低減します。また、ブラウザ実装やAPI実装の差異を吸収するため、前処理条件とポストプロセスの責任分界もコメントとして書き込み、運用時のチケット対応を効率化します。

[役割] 顧客支援プロダクトマネージャーとして応答せよ。

[入力] {{user_issue}}

[制約] 日本語,200文字以内,絵文字禁止

[手順] 1.重要語抽出 2.解決策列挙 3.KPI影響評価

[出力] - 要約:{{summary}} - 推奨策:{{actions}} - リスク:{{risks}}

Step 2

次のStep 3ではアウトプットを検証可能にする評価ラベル設計と例示方法を固めます。評価観点を明確にしながらテストデータ連携の準備を整える流れを続けて確認しましょう。

Step 3: 評価指標とデータセット整備で再現性を担保

Step 3では、構造化プロンプトに適合する評価基準を策定します。期待する出力サンプルを良否セットで用意し、各項目に重要度重みと許容誤差を定義することで、LLMの自己評価や人手レビューを同じスケールで比較できます。さらに、ガードレール違反時の自動リカバリ手順を明文化し、ログから再現できるようステップ番号を付与します。補助的に、評価結果をSQLiteに保存するスキーマを設計し、改善イテレーションごとに差分分析できるようダッシュボード項目も定義しましょう。

{

"dataset_id": "{{dataset_id}}",

"scoring": [

{"metric": "accuracy", "weight": 0.4},

{"metric": "latency_p95", "weight": 0.2},

{"metric": "cost_per_call", "weight": 0.2},

{"metric": "guardrail_pass", "weight": 0.2}

],

"fallback_playbook": "playbook_17_resolve"

}

Step 3

Step 4では検証フローを自動化し、日次で追跡できるメトリクス連動を構築します。これに合わせてシナリオごとのバックテスト手順や異常検知の通知条件を確認していきましょう。

Step 4: 検証パイプラインと監査ログを自動化

Step 4では、評価データと実運用ログを結び付ける検証パイプラインを設計します。自動バッチとオンデマンドの両方に対応できるよう、CI/CDでの再現ジョブと業務時間内の迅速診断フローを整備し、テスト結果をSLOダッシュボードに差し込みます。失敗サンプルにはリカバリ案を紐付け、再発防止チケットをその場で生成できるようにすることが定着の鍵です。さらに、監査対応のために出力と検証ログをハッシュ化して保存し、改ざん検知アラートを設定することで、外部レビュー時の説明コストを下げられます。

pipeline:

schedule: "0 /6 "

stages:

- name: fetch_logs

outputs: local_cache

- name: run_regression

uses: promptsuite/regression@v2

- name: publish_metrics

targets:

- slo_dashboard

- sqlite_archive

alerts:

latency_p95: 8

guardrail_fail_rate: 0.05

Step 4

次のStep 5では得られた洞察を業務設計へ反映させるナレッジ共有と教育の仕組みを整備します。組織全体での技能向上を意識し、トレーニングと運用ガイドの更新手順を確認しましょう。

Step 5: ナレッジ共有と人材育成で定着を加速

Step 5では、検証で得た知見を業務設計や人材育成に接続します。改善ログをもとに研修教材と手順書を更新し、利用者ごとの熟練度に応じたロール別プレイブックを整備することで、属人化を防ぎつつ継続的なスキルトランスファーが行えます。さらに、KPI進捗と学習タスクを結び付けたOKRレビューを実施し、施策の優先順位を合意形成します。その際、フォームテンプレートやチェックリストをNotionやConfluenceに同期し、更新履歴を監査証跡として残しておくと、品質保証プロセスとの整合性が取りやすくなります。

研修テーマ: プロンプト改善の定着

対象: 新任PM/CSリーダー

教材: {{playbook_url}}

演習: ケースレビュー -> 改善提案 -> KPI整理

フォロー: 30日後のリフレクションミーティング

Step 5

最後のStep 6では運用データをもとに継続的な最適化と投資判断を支えるガバナンスを敷きます。評価基準を運用指標へつなぐ方法と経営報告の要点を総仕上げとして確認し、意思決定を促しましょう。

Step 6: メトリクス連携とガバナンスで投資判断を透明化

Step 6では、検証ループとビジネスメトリクスを結び付け、本番運用での改善サイクルを恒常化します。評価ツールから得たスコアを売上影響やCS指標と突き合わせ、意思決定会議に提出するレポートテンプレートを整備し、投資判断の透明性を高めます。加えて、異常検知時のロールバック手順と承認フローを明文化し、緊急時の対応遅延を防ぎます。さらに、事後レビューでリスク残存度とカバレッジの進捗を測定し、ナレッジベースとデータベースの同期状態を監査ログに残すことで、将来のモデルアップデート時にも素早く再評価できる環境を維持します。

INSERT INTO metrics_report (

report_date, accuracy, latency_p95, cost_per_call,

guardrail_pass_rate, revenue_impact, reviewer

) VALUES (

:report_date, :accuracy, :latency_p95, :cost_per_call,

:guardrail_pass_rate, :revenue_impact, :reviewer

);

Step 6

ここからは検証ループ全体を俯瞰し、役割ごとの作業手順と主要指標を具体的に確認します。次節では5ステップの検証サイクルと取得すべきログの要点をコンパクトに整理します。

検証ループとメトリクス

- 要件確認: チームで成功条件・禁止事項・データ同期範囲・承認者・期限・報告形式を共有し、評価対象と優先順位を明確化する。

- データ抽出: SQLiteとログ管理ツールから学習用・検証用サンプルを抽出し、匿名化と品質チェック、例外ケースのマーキングを行う。

- 自動検証: CI/CDでプロンプトテストを実行し、精度・遅延・コスト・安全性の指標を計測しながらアラート閾値を更新する。

- レビュー: QAと業務責任者が結果を確認し、逸脱サンプルへの対応策と運用フローの更新点、教育計画の修正案、報告資料の作成責任を合意する。

- 展開: 承認後にプロンプトとメトリクス設定を本番へ反映し、SQLiteとナレッジベースへログと改善記録を同期し、アラート監視へ反映する。

最後は運用テンプレートと公開前チェックで実務への落とし込み方を固め、継続的改善を支援します。チェックリストと締めくくりのメッセージでチーム全体の行動指針を共有し、次サイクルの準備を整えましょう。

運用テンプレートと公開前チェック

- テンプレートのバージョン、責任者、適用期間をコメント欄に明記し更新履歴を同期したか確認する。

- 評価データとSQLiteの同期が完了し、監査用ハッシュとダッシュボード指標が最新化されているか確認する。

- ガードレール違反時のエスカレーション先とロールバック手順を実運用マニュアルに反映したか点検する。

- 学習教材・FAQ・トレーニング計画が最新プロンプト構造と一致し、関係者へ配信済みか確認する。

- 経営報告用の定例資料に最新KPI、改善施策、リスク対応状況が反映され承認済みかどうかを確認する。

最後のまとめでは組織文化への定着方法と未来志向の連携価値を噛み砕き、実装ロードマップに接続します。締めのメッセージで次期スプリントに向けた学習課題と投資判断の視座を共有し、全員の実行意志を整えます。

プロンプト改善を継続的に進化させるために、上記のテンプレートとチェックを毎スプリントで更新し、成果指標とガバナンスを両立する組織文化を育て、学習ログを未来の投資判断と顧客体験向上に活かし、関係部門の連携速度と継続学習の質を高めていきましょう。

[^1]: Anthropic, “Prompt Engineering for Production Systems”, 2024. https://www.anthropic.com/index/prompt-engineering-for-production

[^2]: OpenAI, “Structured Outputs and Function Calling”, 2024. https://platform.openai.com/docs/guides/structured-outputs

[^3]: Weng et al., “Chain-of-Verification Reduces Hallucination”, 2023. https://arxiv.org/abs/2309.11495

コメント